CST MWS仿真频率设置与高斯脉冲激励时长的关系

看后对“仿真频率为0-200Mhz,高斯脉冲时长为18ns”不甚理解,为什么为18ns,经研究后,特发此贴跟各位大神讨论下:

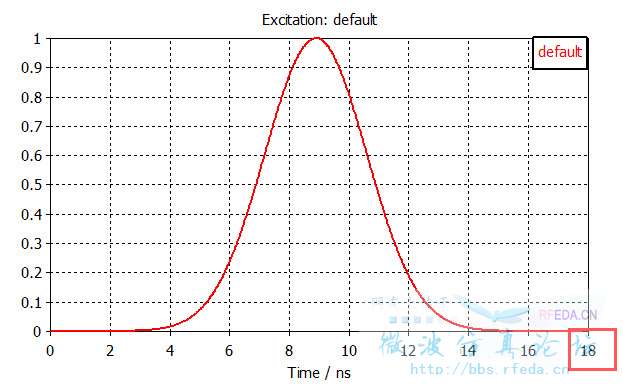

1.仿真频率定位0-200MHz时,default的脉冲宽度确实为18ns,见下图:

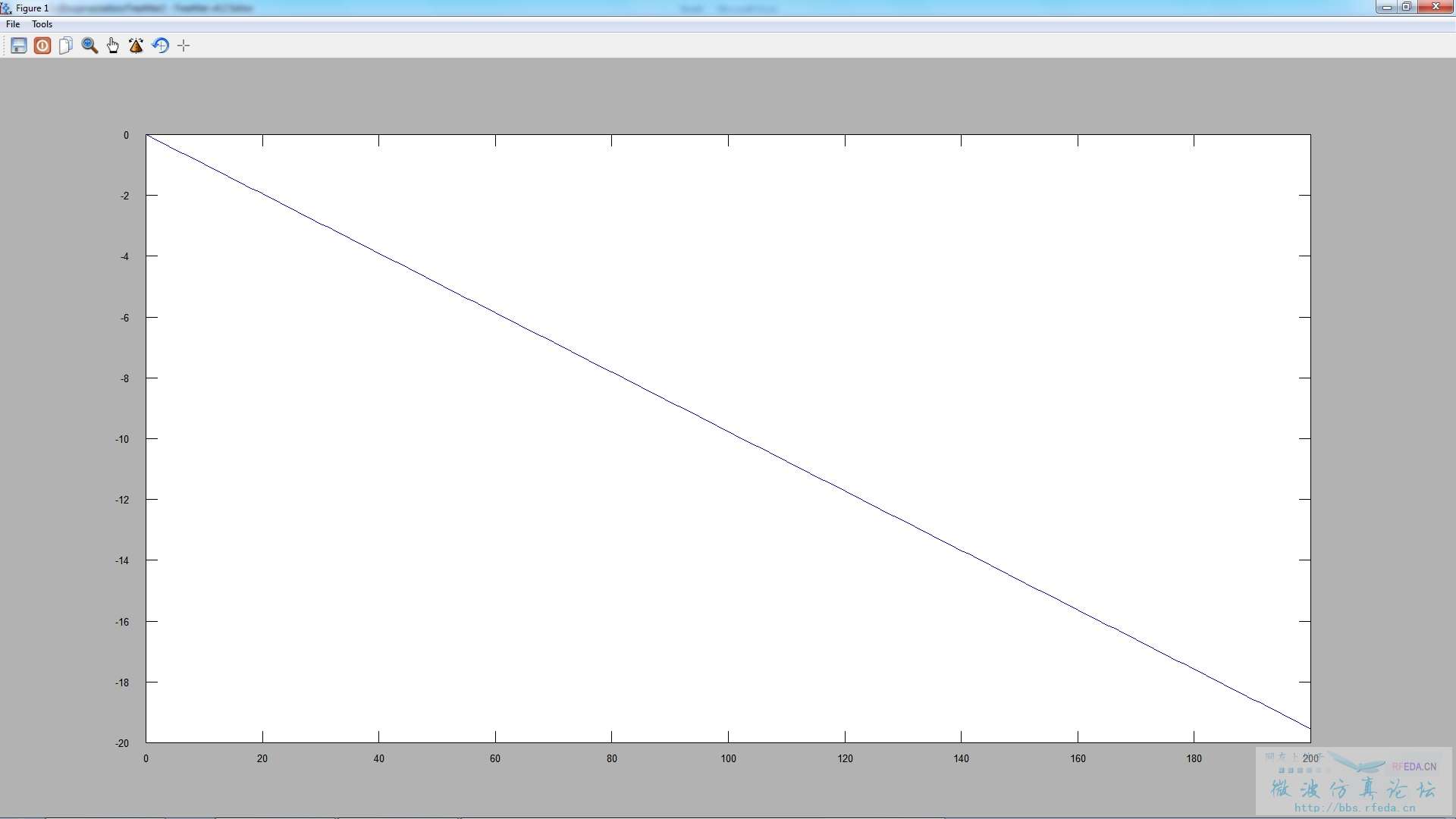

2. 对其作FT后得到其频谱,如下图所示:

结论:脉冲时长的选取是以其频谱下降20dB作为标准选取的。

后续: 我的结论是否正确? 如正确,具体如何求得的能否给出理论依据验证我的想法!

小编研究的好细,好像一般图1那个高斯脉冲很少称为18ns脉冲,也就是CST里那么定义,可能就是为了给那个频段内有效激励。

看到介绍高斯脉冲的文献定义

图1的脉冲如果按下降为峰值10% 则是7.5ns脉冲比较多。

也有按下降3dB计算高斯脉冲宽度的,则是4ns。

这个问题我本身并没有研究过,我是只看CST显示的excitation signal。不过既然提出来了,一起讨论下。

首先在《信号与系统》里激励函数确实叫做“脉冲”,全称叫做“钟形脉冲信号”,它的函数表达式叫做“钟形脉冲函数(高斯函数)”。

对于CST使用-20 dB,这个本身并没有什么特别的理论。-20 dB意味着99%的能量被包括在0-200 MHz之间的信号频谱之内,频谱之外从负无穷到正无穷只有1%的能量。

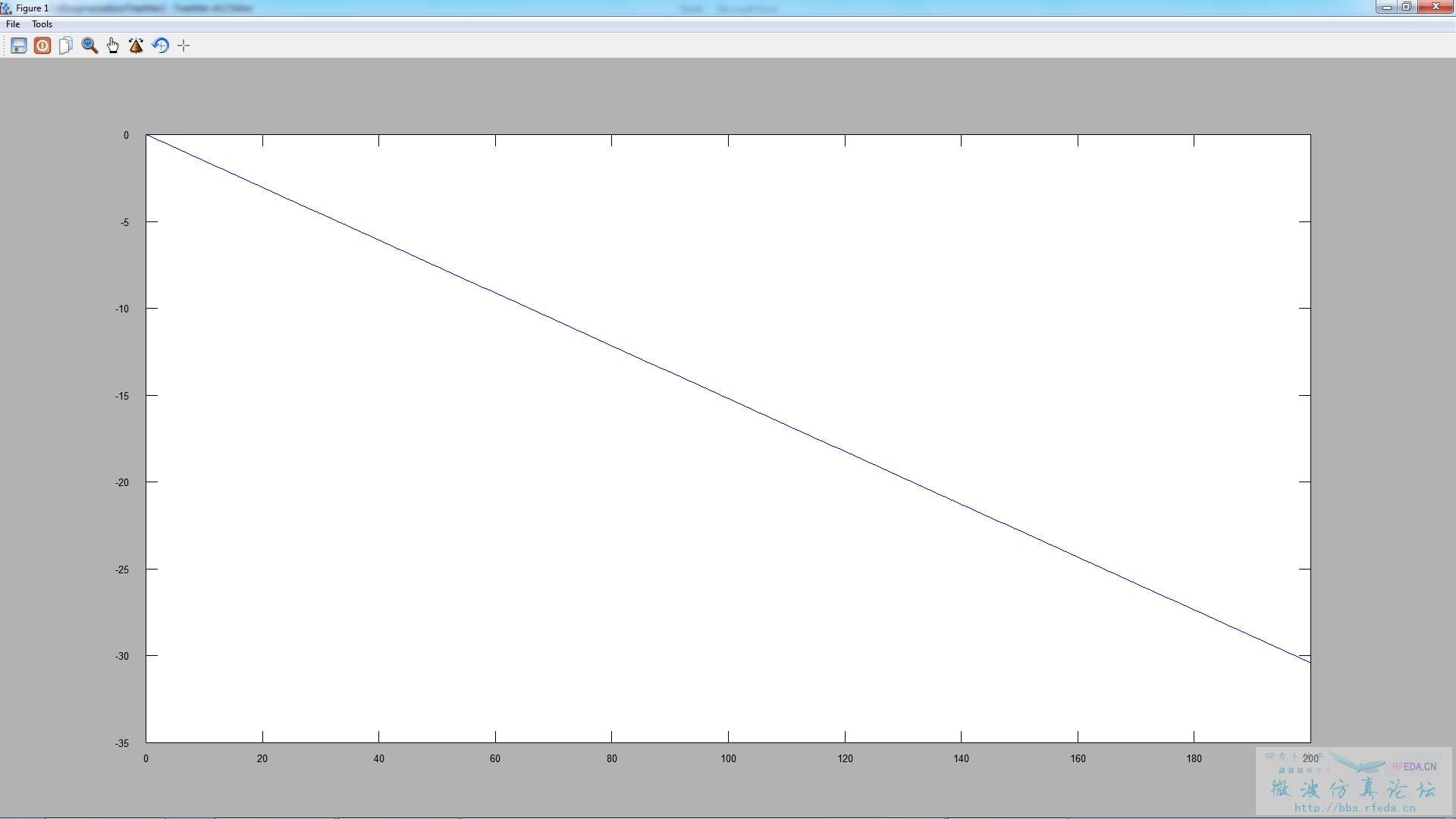

假设现在使用-30 dB作为参考值,意味着有99.9%的能量会被包括在内,对时域的影响是什么呢?根据上面频域信号图,如果要在200 MHz时达到-30 dB,那么意味着频域内脉宽被压缩。按照傅里叶变换的基本原理,时域信号会对应展宽。

那么这就变成了这样一个问题:需要多少硬件资源(仿真时长)来换取更高的仿真准确度(更完备的激励能量)。

用Freemat简单计算一下:(以下只是纯理论验证)

omega = 0 : 200;

tau = 0.045;

F = exp(-(omega*tau/2));

F_log = 10*log10(F);

plot (omega, F_log);

tau等于0.045,高斯脉冲信号在200处是-20 dB左右:

如果要让200处是-30 dB,tau等于0.07:

也就是说,如果要增加0.1%的信号能量,激励信号时长增加接近2倍。作为一个工程应用,问题转化为:“值吗?”

频率越高,高斯脉冲时长越段,脉冲越尖?

看了一下楼上几位的讨论,深感自己当年没有在这个问题上抱有各位的那种钻研精神,惭愧。

我是纯靠多仿真积累经验的选手,说说我的理解。

1、高斯脉冲,本身这个是CST最早的时域算法的一个特色,很多人在用惯了HFSS和FEKO这类频域软件后,不理解高斯脉冲的作用,总是问类似如何加一个xxxGHz的信号之类的问题。其实高斯脉冲只是一个躯壳,本质就是一个包含了用户关注的频率范围的时域信号。说到这,就很明显了,改频率,时域信号就会跟着变。

2、频率范围,高斯脉冲包含的频率范围,理论化的解释就是FFT后,信号能量较为集中的频率内,至于有多集中,那就是hefang和小编的计算了。而说到这,引出一个以前也有很多人问的问题,我关注1GHz,是不是频率范围设置到1GHz即可?这个问题CST官方给出的建议,是用户关注频点的1.3倍,至于原因,就是希望用户关注的频点处的激励能量,不会比最高能量的频点值小太多,因为这样会导致在边缘频点处计算的不精确。

3、能量,能量指的,就是CST的1D result里那个Energy,这个我认为在仿真过程中,唯一能告诉我大概多久能仿真完的参数。只要激励信号还不是0,仿真空间内就会有能量的增加,但是当激励信号=0的时候,就意味着,仿真空间内的能量不会增加了,而这时,就是第一个脉冲时间走完的时候,在Energy曲线上,如果你的模型设置都对,结果不发散的话,那么Energy应该到了那个归一化的0dB并将开始减少。通常我们设置的仿真终止条件,是-30dB,这个-30dB指的就是整个仿真空间内,能量衰减到最大值的1/1000时终止。我做那些用很久时间才能仿真完的仿真的时候,就会盯着energy的曲线,根据斜率,脉冲到达open边界的时间,来判断仿真到底多久能够结束。

4、谐振,谐振是时域仿真里比较不喜欢出现的,因为谐振使得整个仿真区域内的能量,衰减的极慢,这时,我一般会终止仿真,看修改一下频率范围有没有好点(把已知或未知的谐振频点隔离到有用的信号外),如果还没好,时间又紧,我可能会很不情愿的用一下频域或者积分方程法。

5、归一化,我其实一开始,最不理解的就是CST时域的归一化。后来有了TLM,我一看那激励信号都是GV/m的量级,就更糊涂了。后来认真,仔细的研究和试验了一下,明白了这个是怎么回事,大概来说,就是CST的时域激励是个高斯信号,其仿真结果,比如探针、场监视器,在时域上都是高斯信号激励出来的结果,而在频域上,则是用高斯信号激励出来的时域结果FFT后除以高斯信号FFT的结果,这个过程,就是归一化。其归一化的含义,就是把高斯信号的FFT结果,等效成一个在频域各点都=1的激励。这是一个数学上的变化,不是物理上的。而TLM算法,则是在激励的时候,就用一个极大的脉冲,该脉冲的FFT结果,则就是在全频段=1,这是物理上的1,不是数学上的1。

希望能对大家有点帮助。

不早了,该睡了,明天还得去加班。

谢谢解答这个一般人想不到的问题

谢谢你们!

请教小编,您的ft变换在CST里如何实现。谢谢!

与七楼同问,lz就这么消失了啊!

相关文章:

- CST MWS如何导入自己设计的高斯脉冲信号 (05-08)

- 有人知道cst中高斯激励信号的数学表达式么? (05-08)

- 请问在CST中能否模拟高斯光束?如何观察光波通过器件后在远场的偏振特性? (05-08)

- CST中激励一个高斯光束 (05-08)

- CST MWS平面波激励中的激励信号只能用高斯源吗?Why? (05-08)

- 求教为什么天线仿真中一般使用高斯脉冲,它比平顶脉冲的优势在哪 (05-08)